Hexpresso Capture.The.Fic CTF write-up

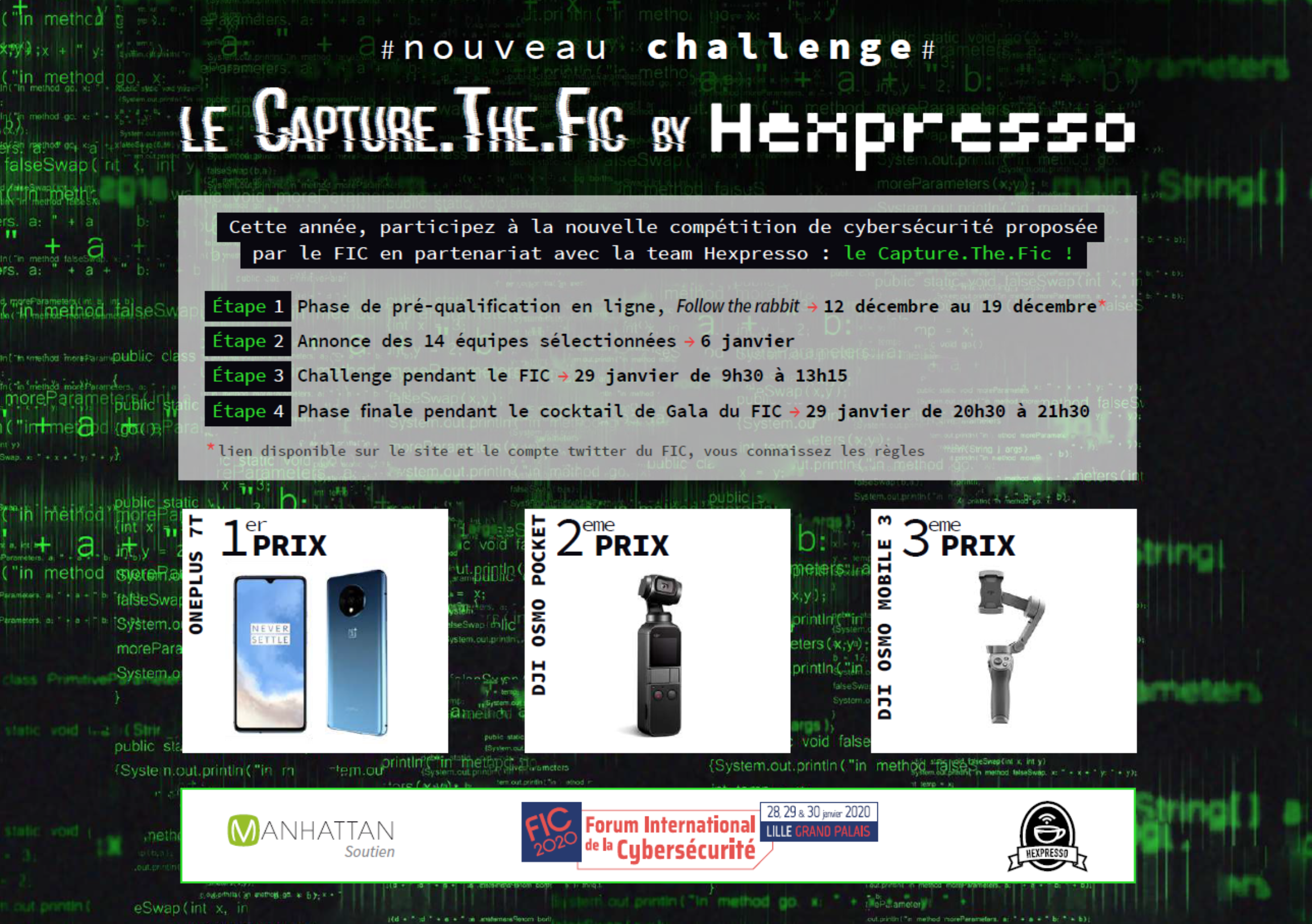

Du 12 décembre au 19 décembre, hexpresso organisait un CTF en ligne. Il s'agissait de se pré-qualifier pour un challenge pendant le FIC. Sans intention de vraiment participer au challenge pendant le FIC, je voulais tout de même essayer de voir jusqu'où je pouvais aller. Je suis loin d'être un [...] Plus...